Die Architektur der Täuschung: Warum Sie nicht Prozesse steuern, sondern Ihre Hypothesen darüber

Tiefgreifende Datenanalysen legen häufig signifikante Diskrepanzen zwischen der Annahme linearer Geschäftsprozesse und der operativen Datenrealität offen. Wo strategisch Homogenität vermutet wird, herrscht auf Datenebene oftmals strukturelle Heterogenität. Diese Komplexität zu ignorieren, ist kein technisches Versäumnis, sondern eine fundamentale Bedrohung für KI-Strategien und digitale Transformationen.

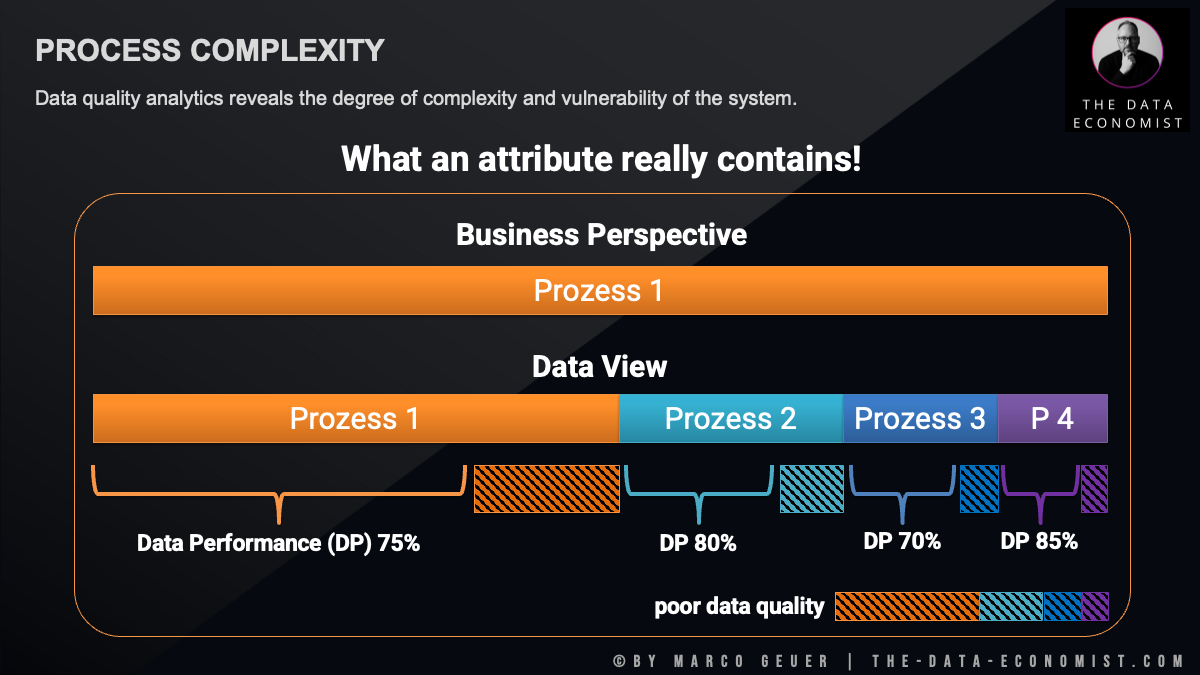

Blickt ein C-Level-Entscheider auf die Prozesslandschaft seines Unternehmens, so präsentiert sich diese meist in beruhigender Linearität. Exemplarisch sei ein Standardprozess wie die „Auftragsabwicklung“ betrachtet: Aus der Geschäftsperspektive erscheint dieser als monolithischer Block. Er suggeriert Einheitlichkeit, vollständige Kontrollierbarkeit und klar definierte Verantwortlichkeiten.

Diese Wahrnehmung erweist sich jedoch häufig als riskante Illusion.

Ein Perspektivwechsel hin zur Datensicht offenbart oftmals ein gänzlich anderes Bild. Was auf strategischer Ebene als singulärer Prozess deklariert wird, entpuppt sich systemseitig als eine Verkettung heterogener Teilprozesse, die künstlich unter demselben Datenattribut subsumiert wurden. Diese Divergenz zwischen der wahrgenommenen Einfachheit auf Managementebene und der tatsächlichen Komplexität der Datenstruktur stellt eine der primären Ursachen für das Scheitern digitaler Transformationsvorhaben dar.

Die verborgenen Kosten der semantischen Überfrachtung

Eine fundierte Analyse demonstriert unmissverständlich die Konsequenzen, wenn Prozessvarianz in Datenbankfeldern verborgen wird. Ein einzelnes Attribut fungiert dabei oft als Sammelbecken für diverse Varianten, die sich keiner Standardkategorie zuordnen ließen. Diese „Attribut-Verdichtung“ hat weitreichende Implikationen:

-

Verzerrte Leistungsmessung: Während das Management davon ausgeht, den Erfolg eines homogenen Gesamtprozesses zu evaluieren, erfasst es faktisch lediglich einen verzerrenden Durchschnittswert. Die Datenlage zeigt häufig folgendes Muster: Während der Kernprozess stabil verläuft, unterliegen die verdeckten Teilvarianten massiven Schwankungen in ihren datenbasierten Leistungswerten. Aggregierte Kennzahlen maskieren diese Ineffizienzcluster. Die Unternehmenssteuerung erfolgt somit teilweise im Blindflug, da die Instrumente Stabilität suggerieren, während einzelne operative Einheiten bereits signifikante Defizite aufweisen.

-

Der Schatten mangelhafter Datenqualität: Besonders kritisch ist die Erkenntnis, dass jeder dieser verdeckten Teilprozesse seine eigene Dimension an Datenqualitätsmängeln mit sich führt. Mangelhafte Datenqualität ist in diesem Kontext kein zufälliges technisches Phänomen, sondern ein strukturelles Resultat der Komplexität. Mit jeder Integration eines neuen Prozessschrittes in ein bestehendes Feld entsteht eine neue Zone der Unsicherheit – eine Akkumulation von Datenrauschen, welche präzise Analysen zunehmend verunmöglicht.

Warum KI an dieser Realität scheitern muss

Die aktuelle Euphorie um Künstliche Intelligenz, klassisches maschinelles Lernen (ML) und Large Language Models (LLM) verleitet dazu, diese Technologien unreflektiert auf bestehende Datenbestände anzuwenden. Das Training von Prognosemodellen auf derart fragmentierten Strukturen führt jedoch zwangsläufig zu Fehlfunktionen:

Algorithmen lernen aus der Datensicht, nicht aus der abstrahierten Geschäftsperspektive. Sie detektieren die statistischen Muster der verdeckten Teilprozesse. Wird ein solches Modell jedoch trainiert, um Parameter der übergeordneten Geschäftslogik vorherzusagen (z. B. „Prognose der Durchlaufzeit für die Auftragsabwicklung“), so resultiert dies in verzerrten Vorhersagen und geringer Modellgüte. Der Algorithmus versucht, eine statistische Gesetzmäßigkeit für eine Entität zu lernen, die in den Daten als homogene Einheit gar nicht existiert. Valide datenbasierte Entscheidungen sind unmöglich, solange die Datenbasis die strukturelle Fragmentierung der Prozessrealität maskiert.

Die Psychologie der Entkoppelung: Karte vs. Territorium

Das eigentliche Problem liegt jedoch tiefer als die Datenarchitektur; es ist in den mentalen Modellen der Führung verankert. Die gefährlichste Annahme im modernen Management ist die Verwechslung von Taxonomie mit Realität. Während C-Level-Entscheider auf strategische Landkarten blicken, die eine Welt linearer Wertschöpfungsketten suggerieren, dokumentieren die zugrunde liegenden Datenströme eine weitaus chaotischere Ontologie des Unternehmens.

Ein mentales Modell ist kein psychologisches Abstraktum, sondern das interne „kognitive Betriebssystem“, mit dem ein Entscheider Informationen filtert und Kausalitäten definiert. Es ist die unbewusste Vorannahme darüber, wie Ursache und Wirkung in der Organisation angeblich zusammenspielen.

In der Praxis bedeutet dies: Führungskräfte steuern selten die realen Prozesse an sich. Sie steuern ihre Hypothesen über diese Prozesse.

Wenn das mentale Modell eine reibungslose, effiziente Pipeline vorsieht, die Daten aber ein fragmentiertes Netzwerk aus Workarounds und Schattenprozessen offenbaren, entsteht eine fatale strategische Entkoppelung. Man verwaltet dann ein Phantombild, während die tatsächliche Wertschöpfung unreguliert bleibt. Dieser Bruch ist kein technisches Versagen, sondern ein erkenntnistheoretisches. Wer die Karte (das Prozessdiagramm) für das Territorium (die operative Datenrealität) hält, verliert die Fähigkeit zur effektiven Intervention.

Strategische Neuausrichtung: Synchronisation von Modell und Realität

Um die Handlungsfähigkeit zwischen Strategie und operativer Exzellenz wiederherzustellen, muss die Führungsebene ihre kognitiven Landkarten proaktiv mit der Datenrealität synchronisieren. Strategische Exzellenz erfordert heute die Bereitschaft, das Unternehmen durch die ungeschönte Linse der digitalen Spur zu betrachten und die eigenen internen Hypothesen permanent zu validieren:

-

Explizierung der Hypothesen: Legen Sie offen, welche kausalen Zusammenhänge Ihr Management-Team als „gesetzt“ betrachtet, bevor Sie auf die Daten blicken. Machen Sie implizite Annahmen explizit, um sie prüfbar zu machen.

-

Forensische Validierung und Auditierung: Nutzen Sie Rohdaten-Analysen explizit dazu, Ihre mentalen Modelle zu falsifizieren, statt lediglich nach Bestätigung für bestehende Strategien zu suchen. Suchen Sie gezielt nach Anomalien in der Attributnutzung – ein Feld, das im Hintergrund für ein Dutzend verschiedener Abläufe genutzt wird, ist der Beweis für ein falsches mentales Modell.

-

Akzeptanz der Nicht-Linearität: Ersetzen Sie das Modell der starren „Maschine“ durch das Modell eines dynamischen „Organismus“. In der Datensicht sind Abweichungen keine Fehler, sondern wertvolle Signale über die tatsächliche Arbeitsweise Ihres Unternehmens. Richten Sie Ihre Steuerungsmechanismen an den realen Teilprozessen aus, nicht am Wunschbild.

-

Symmetrie von Modell und Daten (Governance): Sorgen Sie dafür, dass die strategische Planung und die operative Datenerfassung auf derselben ontologischen Basis stehen, um „semantische Verschuldung“ zu vermeiden. Dies erfordert eine rigide Data Governance und Standardisierung, die verhindert, dass neue Prozessvarianten unkontrolliert in bestehende Datenstrukturen diffundieren.

-

Sanierung vor Innovation: Vor Investitionen in komplexe Prognosemodelle müssen die Zonen mangelhafter Datenqualität eliminiert werden. Dies geschieht nicht durch oberflächliche Datenbereinigung, sondern durch eine Entflechtung der Prozesse.

Fazit

Echte Führung im Datenzeitalter bedeutet die Demut, das eigene Weltbild permanent durch die objektive Härte der Daten korrigieren zu lassen. Wer die Divergenz zwischen seinem internen Modell und der externen Realität ignoriert, verwaltet lediglich eine Illusion von Kontrolle.

Die Qualität einer Führungskraft bemisst sich heute an der Geschwindigkeit, mit der sie eine liebgewonnene Management-Hypothese aufgibt, sobald die Daten ihr widersprechen. Stellen Sie sich abschließend die Frage: Welche Ihrer strategischen Gewissheiten würde sofort in sich zusammenbrechen, wenn Sie die rohen, unaggregierten Daten Ihres Kernprozesses betrachten müssten?

Weitere interessante Artikel:

- Advisory | Impulse Talks | Trainings

- Die stille Vollbremsung: Weshalb fehlende Datendurchgängigkeit die Wertschöpfung gefährdet

- Daten als Vermögenswert: Warum eine Bilanzierung zu kurz greift und trotzdem unvermeidlich wird

- Generative KI und die Zukunft der Einstiegsrollen: Eine Herausforderung für Wirtschaft und Bildung

- Warum die meisten Dashboards scheitern und was wirklich dahintersteckt

Prozessmanagement, Data Quality Management, Data Governance, Operational Excellence, Data Inspired Leadership

- Geändert am .

- Aufrufe: 1091