Die neue Wertschöpfungslogik im Datenzeitalter: Wie Data Governance den Weg von Aufwand zu Wirkung radikal verändert

Eine provokante Ausgangsthese: Wert entsteht nicht durch Technologie, sondern durch strukturierte Datenarbeit

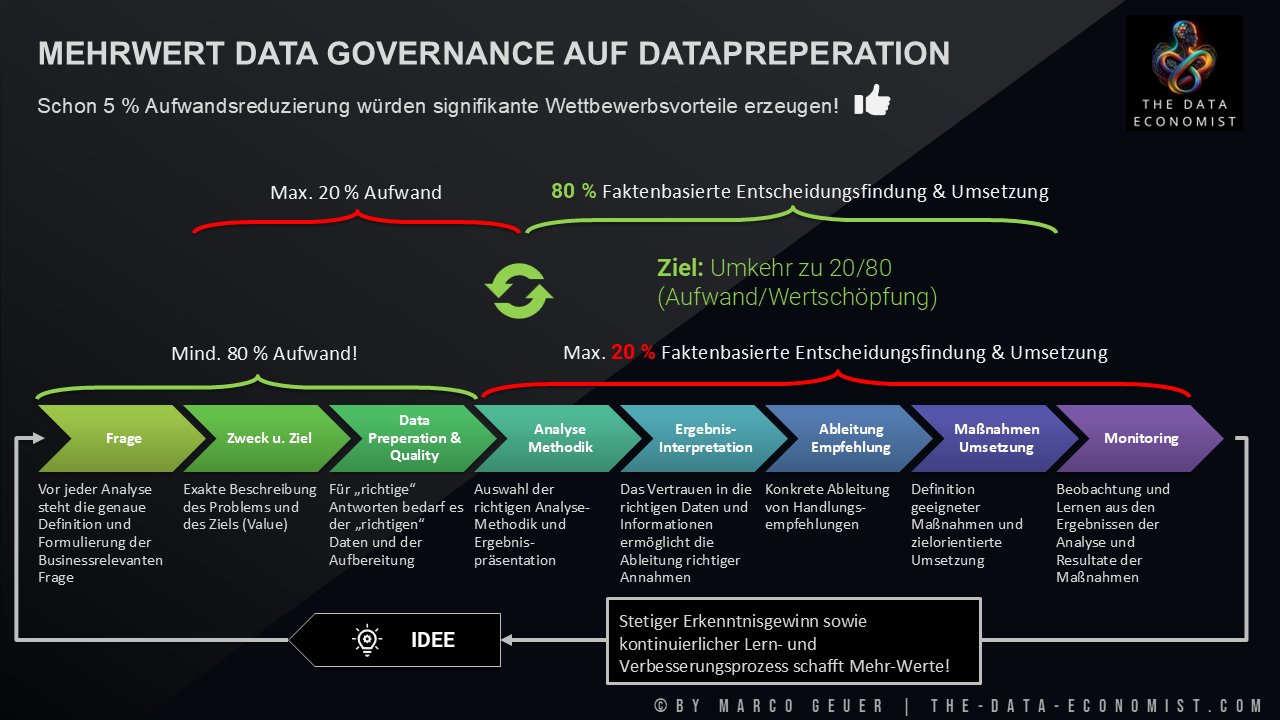

Die zentrale These lautet: Unternehmen schöpfen den Wert ihrer Daten nicht aus technischen Gründen unzureichend aus, sondern aufgrund eines strukturellen Fehlers in ihrer Wertschöpfungslogik. Erst eine konsequente Neuausrichtung durch Data Governance und die Industrialisierung der Datenarbeit kehrt das geltende 80-zu-20-Verhältnis von Aufwand zu Wertbeitrag in ein Modell, in dem Daten als strategischer Produktionsfaktor wirken und KI ihr Potenzial zuverlässig entfalten kann. Diese These fordert die verbreitete Annahme heraus, dass neue Plattformen oder zusätzliche Analysten den Engpass lösen könnten. Tatsächlich entsteht Fortschritt dort, wo Unternehmen bereit sind, den unsichtbaren Aufwand vor der Analyse systematisch zu eliminieren.

Die Realität in Organisationen: Hoher Aufwand, geringe Wirkung und ein Wertstrom voller Reibungsverluste

In vielen Organisationen dominieren nach wie vor langsame, fragmentierte und fehleranfällige Datenprozesse. Trotz moderner Technologien verbringen Teams unverhältnismäßig viel Zeit mit Klärungen, Datenauffindung, manueller Bereinigung, Interpretation und Abstimmungsschleifen. Fehlende Semantik, widersprüchliche KPI-Definitionen und unklare Verantwortlichkeiten verzerren Ergebnisse und führen zu widersprüchlichen Berichten. Diese operative Realität behindert Geschwindigkeit, Vertrauen und Skalierbarkeit und bindet Ressourcen dort, wo kein Wert entsteht. Datenteams werden zu Reparaturbetrieben historisch gewachsener Datenlandschaften, anstatt als strategische Partner für Entscheidungen zu agieren. Hinzu kommt, dass die hohe Erwartung an KI-Systeme den Druck auf die Datenbasis weiter erhöht: Ohne belastbare Qualität, klare Herkunft und konsistente Definitionen verstärken KI-Systeme inkonsistente Strukturen und offenbaren organisatorische Schwächen schonungslos.

Die Kernursache des Problems: Ein ineffizientes Vorfeld, das den Wertstrom systematisch ausbremst

Die Analyse zeigt, dass das Kernproblem nicht im technischen Stack, sondern in der Struktur des Wertstroms liegt. In vielen Unternehmen entfallen 60 bis 90 Prozent des Gesamtaufwands auf vorbereitende Tätigkeiten, bevor analytische Arbeiten überhaupt beginnen können. Der Wert entsteht jedoch erst in Interpretation, Umsetzung und Veränderung – ein Bereich, der bislang systematisch unterversorgt bleibt. Ursache dafür sind fehlende Verantwortungsmodelle, mangelnde Prozessstandards, isolierte Datenhoheiten, fehlende Metadaten sowie ein unzureichendes Verständnis der End-to-End-Datenprozesse. Diese strukturellen Defizite erzeugen Abhängigkeiten, Wiederholungen und Fehlerpfade, die entlang des gesamten Wertstroms fortwirken. Selbst Experten geraten unter Druck, da sie gleichzeitig Qualität sichern, Definitionen aushandeln, Geschäftslogik übersetzen und technische Schulden kompensieren müssen. Die Organisation arbeitet im Modus Ad-hoc-Reparatur, statt im Modus einer industriefähigen Datenproduktion. Der Anspruch, Daten demokratisiert oder KI-ready zu machen, scheitert deshalb nicht an Technologie, sondern an fehlender Governance und unzureichender Datenkompetenz in den Fachbereichen.

Der Weg zur Umkehr: Wie Governance, Prozesse, Technik und Kultur Datenarbeit industrialisieren

Die strukturelle Umkehr des Verhältnisses von Aufwand zu Wert entsteht durch eine konsequent industrialisierte Datenarbeit. Diese basiert auf vier Handlungsfeldern. Organisatorisch benötigen Unternehmen klare Verantwortlichkeiten, verbindliche Entscheidungsmechanismen und Governance-Gremien, die Prioritäten, Standards und Compliance sichern. Prozessual sind eindeutige Startprozesse, vollständige Anforderungsdefinitionen, konsistente KPI-Modelle und ein End-to-End-Verständnis der Datenwertschöpfung erforderlich. Technisch beschleunigen automatisierte Qualitätsprüfungen, Datenkataloge, wiederverwendbare Datenprodukte und standardisierte Pipelines den Wertstrom erheblich. Kulturell schließlich müssen Datenkompetenz, Transparenz, psychologische Sicherheit und eine gemeinsame Sprache für Daten etabliert werden, sodass Fachbereiche Verantwortung für Daten übernehmen und nicht nur Konsumenten kuratierter Ergebnisse sind. Erst dieses Zusammenspiel erzeugt Reproduzierbarkeit, Konsistenz und Skalierbarkeit. Es reduziert operative Risiken, erhöht die Verlässlichkeit von Entscheidungen und schafft die Grundlage für verlässliche KI-Anwendungen. Zugleich werden Analysten entlastet, da manuelle Bereinigungsarbeiten und Abstimmungsschleifen deutlich abnehmen und sie sich auf die Wertschöpfung konzentrieren können.

Das neue 20-zu-80-Modell: Mehr Geschwindigkeit, höhere Qualität und skalierbare KI als Ergebnis

Im Ergebnis entsteht ein neues Wertschöpfungsmodell: 20 Prozent Aufwand in der Vorbereitung, 80 Prozent Wertschöpfung in Analyse, Interpretation und Umsetzung. Unternehmen gewinnen Geschwindigkeit durch kürzere Analysezyklen und konsistente Prozesse. Sie verbessern die Qualität von Entscheidungen, weil Informationen verlässlich und nachvollziehbar sind. Sie skalieren Daten- und KI-Initiativen, da standardisierte Datenprodukte und Governance-Mechanismen Wiederverwendbarkeit möglich machen. Sie reduzieren Risiken, weil Fehler früher erkannt und systematisch verhindert werden. Vor allem aber setzen sie KI dort ein, wo sie ihre Wirkung entfalten kann: auf einer Grundlage sauberer, semantisch konsistenter und klar definierter Daten. Damit wird Data Governance vom Kontrollmechanismus zum strategischen Enabler und zur Industrialisierungslogik moderner Datenarbeit.

Schlussfolgerung: Warum Data Governance zum strategischen Produktionsfaktor wird

Die Zukunft gehört den Organisationen, die Datenprozesse nicht als Nebenprozess, sondern als industriellen Kern ihrer Wertschöpfung verstehen. Wer das heutige Verhältnis von 80 zu 20 Aufwand zu 20 zu 80 Wertbeitrag konsequent umkehrt, stärkt Geschwindigkeit, Qualität, Skalierbarkeit und Innovationskraft nachhaltig. Data Governance schafft dafür die strukturelle Grundlage und verbindet Technologie, Organisation und Kultur zu einem belastbaren Betriebsmodell. Unternehmen, die diesen Schritt gehen, nutzen Daten als strategischen Produktionsfaktor, erhöhen die Wirksamkeit ihrer Fachbereiche und setzen KI dort ein, wo sie nachhaltige Wirkung erzielt. Damit wird dateninspirierte Entscheidungsfindung zum Motor einer neuen Wertschöpfungslogik, in der Daten nicht verwaltet, sondern erfolgreich genutzt werden.

Weitere interessante Artikel:

- Advisory | Impulse Talks | Trainings

- Die größte Datenlüge: IT ist verantwortlich – Business schaut weg

- Warum dauerhafte Datenbereinigung keine Lösung ist!

- Data Governance: Der schlafende Riese, der unsere KI-Zukunft sichert

- Daten als Vermögenswert: Warum eine Bilanzierung zu kurz greift und trotzdem unvermeidlich wird

Datenqualität, Digitalisierung, Data Governance, Data Analytics, Data Preperation, Datenindustrialisierung, Datendurchgängigkeit

- Geändert am .

- Aufrufe: 712